J'ai vécu mes premières soutenances "IA générative" cette année, c'était une expérience très perturbante. J'en parlerai plus en détail à l'occasion (parce que là : dodo), mais c'était totalement dingue.

Or donc : dans une UE de master 1, nous demandons aux étudiant.e.s de lire un article scientifique (à choisir dans une liste constituée par nous, les enseignant.e.s).

Iels doivent le comprendre, et ensuite nous restituer cela sous forme d'une présentation de 10 minutes où iels nous expliquent la problématique abordée, son contexte, l'état de l'art, la méthode proposée, la nature de l'évaluation des résultats, etc.

Ils ont plusieurs semaines pour faire ça (genre au moins deux mois...)

Evidemment, il y a toujours de supers étudiant.e.s qui ont tout pigé, sont super clair.e.s, répondent à nos question, et on est content.e.s... et des glandu.e.s qui n'ont pas fichu grand chose, qui ont une compréhension vague et superficielle de l'article, et finissent avec une pas très bonne note, bref, la vie d'enseignant.e.

J'étais dans l'un des jurys qui a fait passer ces soutenances hier, et on a eu pour la première fois des présentations "systèmes d'IA génératifs" :

Premier cas : la présentation n'est constitué que de gros blocs de texte (genre 10 lignes par diapo), que l'étudiant.e annone sans même regarder le jury.

Pendant 10 minutes.

Aucune illustration issue de l'article (ni de l'architecture du système proposé, du dispositif robotique expérimental utilisé pour les tests, ni des graphes et figures de résultats : rien), juste du texte.

Et pas n'importe quel texte : juste un résumé très vague, disant à peine plus que le résumé des auteurs en début d'article.

Le collègue et moi on a passé un très mauvais moment, c'était atroce d'assister à ça.

Mon hypothèse : la personne n'a pas lu l'article, à demandé à ChatGPT de le résumer en deux pages et a ensuite copié-collé le résultat sur 10 diapos.

Seule certitude après les questions : cette personne n'avait rien compris du papier.

Deuxième exemple, et pire truc que j'aie jamais vu dans un tel examen : la présentation *IA générative totale* !

@LegalizeBrain l'avantage c'est que c'est encore suffisamment mauvais pour que tu t'en rendes compte

Les diapos ont été générées par Gamma, aucun doute là dessus : c'était écrit dans un coin des slides.

Je vous laisse visiter le site web qui correspond : https://gamma.app/fr

En gros, vous fournissez du contenu, un système d'IA à la con vous génère des diapos.

Le rêve humide de tout le middle-amangement linkedinien.

Sauf que le contenu fourni devait aussi sortir de plusieurs systèmes d'IA générative :

Un texte confus, vague, avec les bon mots-clefs mais un peu dans le désordre. Aucune équation, aucun algorithme, juste des fancy bullet points.

Et des images, des putains d'images, sur chaque putain de diapos. De ces images atroces générées par des systèmes d'IA, avec ce style dégueulasse qu'on reconnait à 100 m.

@charles @LegalizeBrain à terme c'est pas particulièrement bénéfique pour un étudiant de tricher comme ça mais quand on voit les progrès réalisés par tout ceci, un jour il est probable qu'il sera plus difficile de détecter la triche. Comme le IA qui ont arrêté de dessiner des mains à 6 doigts ou le fait que deepl est maintenant bien plus performant que moi pour traduire en anglais

Un article scientifique en Intelligence Artificielle, pour celleux d'entre-vous qui n'en sont pas familier, ça regorge de contenu graphique : description du système avec des boîtes et des flèches, algorithme en pseudo-code, courbes de résultats...

Bref, dans l'exercice dont je vous parle ce soir, il va de soi que ce contenu va être copié et intégré à la présentation, pour appuyer les explications.

Là non : plein d'images, aucune issue de l'article.

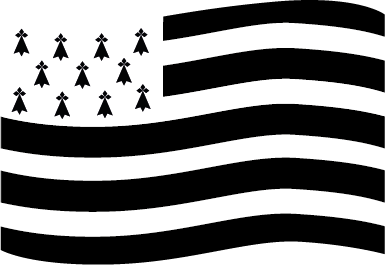

Et puis des diagrammes à la con, du genre un de ces trucs qui de loin ressemble à 4 axes avec éléments positionnés de manière qualitative, du genre le mème classique ci-dessous.

Sauf que là les noms des axes ont un vague rapport avec l'article, et les items disposés sont des mots-clefs de l'article, mais qui n'ont aucun rapport avec les axes. Du pura charabia graphique qui sent son IA générative à plein nez.

Et puis la personne qui parle, en mode linkedin x ChatGPT : les mots sont là, mais pas vraiment dans l'ordre. C'est vraiment comme quand tu demandes à ChatGPT de parler d'un sujet technique que tu connais bien : ça semble, superficiellement, parler du truc, mais rien n'ai vraiment vrai, rien n'est clair, des truc à moitiés faux... à croire qu'on nous a envoyé non pas un humain, mais un androïde connecté à internet.

@charles @LegalizeBrain pour une pres orale, oui, tu as raison.

Pour un devoir écrit je pense qu'il sera bientôt compliqué de déceler celui généré par IA

J'oublie de préciser : sur l'unique diapo qui présente les résultats de l'article, il y a des bullet points (pas clairs, et mentionnant des chiffres dont je ne suis même pas sûr qu'ils soient dans l'article) et...

...

une image générée par une IA représentant un graphe scientifique générique. Je vous le reproduits ci-dessous tellement j'ai halluciné.

Il y a 10 figures de vrais résultats scientifique dans l'article, mais l'étudiant.e nous colle une fausse figure scientifique.

Pour... Pour montrer à des scientifiques (nous, dans le jury) à quoi ressemble un graphe scientifique en général ?

A quoi ça rime ?

(à rien)

Démonstration finale qu'on avait bien affaire à un LLM incarné et pas à un humain : doutant sérieusement de la compréhension du papier, et après quelques questions sans réponse, ou avec réponse fausse, je demande : "c'est quoi la fonction schmürz* ?"

Le schmürz en question, c'est un truc hyper classique, utilisé dans l'article et que l'étudiant.e a mentionné plusieurs fois pendant la présentation confuse qui avait précédé les questions.

* : cette fonction a demandé à garder l'anonymat

Là, au lieu de dire juste "je sais pas", l'étudiant.e prend une craie se tourne vers le tableau et écrit "schmürz =" et s'arrête là.

Comme si écrire ces deux mots allait nécessairement permettre de prédire le prochain item le plus probable et donc de finir l'explication...

Ces deux spécimens se sont retrouvés dans une série de 4 soutenance vraiment pas terribles, à la pause qui a suivie, mon collègue et moi nous sommes demandés ce qui se passait, si s'en était fini de l'enseignement supérieur, si par hasard c'était pas une caméra cachée... on n'avait jamais vécu un truc pareil.

@pizzaroquette Je te jure qu'on était fâchés, hier : on avait l'impression que ces étudiant.e.s n'avaient aucun respect pour nous et notre expertise.

Envie d'utiliser le temps de questions pour les questions suivantes :

Tu crois berner tes profs avec des merdes pareilles ? Tu nous prends pour des cons ? Tu me fais perdre 20 minutes de ma vie alors que tu n'as pas travaillé ?

@LegalizeBrain je comprends la sensation et le choc

@LegalizeBrain enfin un moyen de préparer nos cours plus vite, trop bien 🤩

@oschwand @LegalizeBrain c'est ce que m'a sorti un gars qui enseigne dans une école privée post bac en formation pédagogique de l'ED l'année dernière 😬. Pour lui, c'était vraiment formidable, ses cours étaient prêts beaucoup plus vite, juste besoin de donner la trame et vaguement relire, il (enfin, toute l'équipe pédagogique) notait les rapports de stage avec ia ("tu comprends, suffit de bien écrire le prompt et il met la note qu'on aurait mise, avec des commentaires" ).

@LegalizeBrain t'as essayé de confronter la personne pendant les questions ? Mettre la tête dans le pipi ?

Si les figures, chiffres, propos sortent de nulle part faut le dire je pense. Même si la personne ment, au moins tu pointes le pb devant tout le monde

@LegalizeBrain je sais pas si c'en est fini de l'enseignement supérieur. Peut être mettre en gardeau moment où le boulot est donné que vous n'êtes pas dupes quand c'est réalisé par une IA et que vous vous rendez bien compte que l'étudiant n'a rien pigé ça dissuaderait les étudiants

@LegalizeBrain j'avais un prof qui, avant le premier devoir maison (en informatique) nous avait expliqué qu'il mettait un lien unique pour vérifier si le sujet avait été ouvert par tel ou tel étudiant et qu'une fois il avait grillé un mec qui lui avait dit qu'il s'était planté d'adresse en envoyant sa copie par mail alors qu'il avait même pas ouvert le sujet.

Je sais pas si c'était vrai mais force est de constater que personne n'a essayé de rendre son devoir en retard...

@Lubedyle @LegalizeBrain hier en ramenant junior du sport avec un copain avec lequel il fait parfois des exposés, en 3e, j'apprends que le copain a toujours un onglet chatgpt ouvert sur sa tablette.

Je vous dis pas comme je suis parti au 1/4 de tour en mode Nein, niet, verboten, pas de ça ici, si je vois que c'est utilisé dans vos prez ça va chauffer toussa.

C'est foutu je crois, ça gangrène de partout dès le + jeune âge

@jaztrophysicist @Lubedyle @LegalizeBrain Récemment une collègue (pas francophone native) a fait réécrire par ChatGPT un bout d'un projet de recherche. Dans ce qu'elle avait écrit ça avait évité quelques fautes et formulations hasardeuses de non-native. Dans mon passage, un truc institutionnel pointu, ça avait remplacé aléatoirement des mots par des synonymes plus ou moins proches. En perdant 90% des termes institutionnellement corrects au passage.

@doctunder ce qu'on lui a dit c'est : "pourquoi illustrer les résultats avec une figure générée par une IA qui illustre juste à quoi ressemble un graphe scientifique, alors que nous on sait ce que c'est, un graphe ? Pourquoi ne pas avoir utilisé l'un des nombreux graphes de l'article, pour nous l'expliquer et le commenter ?"

@LegalizeBrain bien joué !

En plus le graph que tu montres ressemble pas du tout à un graphe scientifique, on dirait un truc marketing startup nation pas très crédible 😐

@doctunder Le tableau de bord d'un trader dans un film Hollywoodien, je dirais.

@LegalizeBrain mais oui !! La slide de fond dans les réunions, ridicule mdr

@LegalizeBrain je suis en train de visualiser l'étudiant-e qui buggue en attendant que chatGPT fasse l'autocomplete lui-même… au tableau.

@orange_lux c'était exactement ça !

On en a rigolé, après, avec le collègue.

@LegalizeBrain parce que c'était soit ça, soit iel était encore baigné-e dans son illusion de compétence, en se disant que ça allait passer, que quelque chose se passerait qui l'aiderait à finir.

@LegalizeBrain Un de nos étudiants est un adepte de ChatGPT. Comme l’a résumé une collègue "il ne sait rien faire sans, c'est effroyable".

Quand je l'ai vu essayer de me cacher qu'il s'en servait, je lui ai dit "Vous savez, moi je m'en fous. Ça vous rend con et paresseux, mais faites comme vous voulez. Vous aurez une sale note de toute façon vu que vous savez pas vous en servir. Mais quand on se rendra compte en entreprise que vous servez à rien, vous allez pas faire long feu et il faudra pas venir pleurer. Je dis ça pour vous."

Il s'est fait virer de son alternance une semaine avant la fin de sa période d'essai. Il lui ont dit d'arrêter de venir pour pas perdre de temps à le surveiller. 🤷♂️

Tout ça pour dire que je pense que ce genre de truc va finir par se savoir et je pense que le ChatGPTisme va finir par devenir une marque de loosers que personne ne voudra porter. Et que l’enseignement supérieur y survivra.

@LegalizeBrain Au-delà de la question de l’utilisation de « l’IA », comment tu peux faire ce genre d’erreur dans une présentation en master 2 >< ?

@Lubedyle @LegalizeBrain Je pense que les notes très basses des usagers d'IA seront plus marquantes pour les candidats suivants que ces mises en garde auxquelles ils ne croiraient probablement pas.

@Lo @Lubedyle @LegalizeBrain oui! C'est difficile à prouver et fatiguant, décourageant.

Je me borne à donner des notes entre 1 et 4 sur 20 en expliquant ce qui ne va pas, en posant des questions pour faire voir que le sujet n'est pas compris etc.

Je me dis que c'est plus efficace, s'ils racontent à leurs copains la prof n'a rien vu mais j'ai eu 1/20, et basta

@LegalizeBrain https://gamma.app/docs/Quantativite-binaire-telurique-du-boson-de-Wildom-7gdl7rw32ha529c

Ça marche super bien quand même, j'suis convaincu qu'on est a l'aube d'une nouvelle ère de la physique

@zurbo @LegalizeBrain z'êtes cruels, j'ai tapé dans un moteur de recherche boson de wildom pour savoir ce que c'est au lieu d'aller dormir après une journée à évaluer un article à modifier de manière majeure

Bouuuuuu

@LegalizeBrain @pizzaroquette J'espère que tu n'as pas eu que ces deux spécimens et que le reste de la classe a fait qqch de plus sérieux. Pour avoir été experte dans des oraux dans un domaine technique, t'en a toujours 2-3 qui on rien pigés ou tu passes 20m à chercher ce qu'ils savent. Même perte de temps, mais je pense que regarder des prés. générées en plus ça fait saigner les yeux 😖

@LegalizeBrain j'ai l'impression que la seul question aujourd'hui à poser à des étudiants est : avez vous envie d'apprendre ? Et qu'avez vous envie d'apprendre ? Mais ces questions se pose des le plus jeune âge.

Le travail forcé, sur des sujets forcés ou l'élève n'y trouve aucun intérêt est la raison première du désintérêt et du coup : j'menfoutisme.

Montessori à posé ce constat il y a bien longtemps. C'est par l'envie de connaissance que l'on se rend compte de la nécessité de travailler.

@LegalizeBrain c'est le pouet champion pour mon weekend, cette image de graph générique Lit enosprit

@LegalizeBrain tu pourrais pas éditer ce premier pouet de fil qui annonce juste que tu vas faire dodo pour qu'on comprenne que c'est un pouet de début de fil quand on le voit passer ?

(#purisme je crois, signe de vieillissement certain)

Bon, on a eu des trucs plus classiques, du genre "J'ai pas mis les équations, y'avait pas le temps de les expliquer en 10 min", qui se transforme, au fur et à mesure que les questions se font plus incisives en "en fait j'ai pas vraiment compris les maths".

@LegalizeBrain quand je lis ça et avec ce que je vois, je me pose plein de questions. La première est que je vois beaucoup d'étudiants qui ont très peur de faire des erreurs. Il faut qu'il y ait un algorithme de réponse aux questions posées car sinon "je ne sais pas faire". L'impression que j'en ai c'est qu'il y a une vraie peur de ne pas savoir et une incapacité à tourner autour du problème, à chercher à le résoudre par eux-mêmes. Ils préfèrent de loin chercher sur internet que d'essayer et se tromper.

(+ les étudiants flemmards, pour quelques raisons que ce soit, et ceux qui pensent qu'ils vont s'en sortir en pipotant)

Je me demande dans ceux qui ont utilisé les IA génératives la part de la première catégorie et la part de la seconde.

@CCochard @LegalizeBrain

Un exemple : dans la résolution d'un problème de maths, il est souvent nécessaire d'identifier quelle partie du cours, quel théorème va être utile pour répondre à la question posée. Sans ça, on a des réponses qui consistent en un gloubiboulga de trucs du cours concluant par « donc x=0 ». (Cf les blagues sur l'âge du capitaine !)

Dans son travail, @ClaireLomme a montré comment elle adaptait les énoncés et vérifiait que ses élèves comprenaient la situation décrite. (C'est la seule fois que j'ai vu cette question importante prise au sérieux.)

À l'inverse, dans les futurs programmes de cycle 1 ou 2, la méthode suggérée pour vérifier que les élèves comprennent bien les consignes et n'ont pas mécaniquement effectué la seule opération plausible consiste à les « piéger » : l'exemple donné consiste à ajouter le mot « plus » alors qu'il faudra faire une soustraction...

Je conçois bien qu'avec une telle pédagogie, on construit des étudiants anxieux de ne pas comprendre ce qu'ils font.

@Lubedyle ça, je l'ai fait pour un travail à rendre par écrit, dans une autre UE, je vous dirais bientôt ce que ça a donné.

J'ai dit : "Je ne peux pas vous empêcher de faire appel à un système d'IA pour générer ce devoir, et je ne vais même pas essayer de savoir si vous l'avez fait ou non : si vous le faites, ça sera merdique et vous aurez une mauvaise note"

@Lubedyle Mais je ne me fais pas d'illusion : quand tu dis aux étudiant.e.s de ne pas copier sur leurs voisin.e.s car on le détecte facilement, il y en a qui se croient plus malin.e.s et qui copient quand même...

Pour cette UE là, je ne suis pas le boss, ce n'est pas moi qui leur ai donné les instructions, je ne sais pas si ça a été dit explicitement.

@LegalizeBrain @Lubedyle Il faut se mettre à la place des étudiant·es : rendre rien ou rendre un truc qui leur semble bien, bosser fort ou bosser un peu pour un résultat qui leur semble meilleur. De leur point de vue de débutant·es, et aussi parce que le matraquage est énorme en ce sens, l'IAG fait mieux et à moindre effort. Bien sûr c'est complètement louper l'objet même des études (étudier, oui), mais les examens ça stresse et amène à faire des bêtises (tricher, bouh).

@1HommeAzerty @LegalizeBrain @Lubedyle Ce qui est triste c'est que cela se voit, imaginer le nombre de ceux chez qui ça se voit pas... (les futés)

@LegalizeBrain @Lubedyle En fait la situation par rapport à avant, quand on demandait à la grande sœur ou au cousin de faire le truc à notre place, cette situation a juste évolué un peu : tout le monde a un cousin, il est toujours disponible, malheureusement c'est un immense fumiste. Dans un sens c'est plus facile pour nous mais c'est un piège pour plus d'étudiant·es.

@Kahte oui, complètement. Ma fille a récemment eu 14/20 à un devoir d'histoire qui lui avait demandé un gros weekend de travail. Plusieurs élèves de sa classe ont rendu un travail 100% chatgpt ( ils s'en vantaient dans les couloirs du lycée), ils ont eu entre 18 et 20. Quand on pense à la pression parcoursup, ma fille de dit qu'elle a été bien bête, que ces élèves ont plus de chance d'obtenir une filière sélective qu'elle.Elle était effondrée .Ça me dégoûte.

@MarCandea @Kahte En fait il s'agissait d'un devoir à l'école, mais dont le thème avait été donné à l'avance. Ma fille a vu plusieurs élèves sortir des "brouillons" de leur sac , et les recopier consciencieusement. C'est aussi ce dont ils se vantaient dans la couloirs. J'ai cessé d'imaginer qu'en discuter avec les enseignants est possible ( c'est ma N°3 ...), car ils considèrent que nous ne devons pas remettre en cause leur pédagogie ni leurs méthodes d'évaluation, j'ai arrêté de me faire du mal

@ileglaz @Kahte ça dépend des équipes pédagogiques, c'est pas toujours facile, je comprends.

Il s'agit pas de leur donner des conseils, mais de leur demander quelle est la politique de l'établissement sur ces questions de ChatGPT etc, à propos des pratiques croissantes et revendiquées des élèves, pour pouvoir se positionner aussi en tant que parents. C'est mieux quand les profs et les parents font équipe, de manière constructive...