Tous ces prix Nobel sur l’intelligence artificielle tombent la semaine où je travaille mon prochain cours sur… pourquoi il ne faut pas utiliser l’intelligence artificielle 🙃 (contexte précis : utilisation de ChatGPT dans le travail de mémoire de master MEEF en SVT)

Après un autre cours sur le biais de genre et les sciences (magnifiquement et malheureusement illustré là aussi par cette semaine), le comité Nobel doit penser que j’ai une dent contre lui 😈

Verdict du topo aux étudiant·es sur ChatGPT et mémoire de Master MEEF : « plus jamais j’utilise ChatGPT ! »

J’avoue, je ne suis pas mécontent de moi 😌

@ffigon Tu devrais le partager ici, ça peut servir à d'autres !

Oui, on prend volontiers !

On devrait se faire une base collective d'arguments qui tuent l'envie de se servir de ce machin dans l'oeuf.

Tu prends ça sous quel angle ? impacts sociaux et environnementaux, ou bien textes farfelus, biais, dépossession de ce qu'ils ont vraiment voulu dire, ... ? Tout ça à la fois ?

@flomaraninchi @jaztrophysicist la réponse D 😁 je ne sais pas ce qui a eu le plus de poids, mais je pense que la partie « vous risquez de plagier ou faire des erreurs grosses comme les GAFAM à votre insu, et ça on peut le détecter » a dû avoir un effet le plus important. Après ils étaient aussi réceptifs aux problèmes éthiques (travail du clic, environnement -ce sont des MEEF SVT, donc je voulais encore moins lâcher là-dessus)

Je partage donc les diapos supports utilisées pour expliquer les dangers et problèmes à utiliser ChatGPT dans le cadre d'un mémoire de Master MEEF SVT, à toutes fins utiles (en espérant que le lien fonctionne !).

N'hésitez pas à commenter (notamment les aspects techniques, je ne suis absolument pas spécialiste -ça se sent dans l'utilisation de sources principalement secondaires ;)). Je propose aussi dans ce fil de reprendre le contenu du diapo en mode captures d'écran.

2nde partie : argumentaire contre l'utilisation de ChatGPT (dans le cadre du mémoire MEEF, mais aussi plus largement)

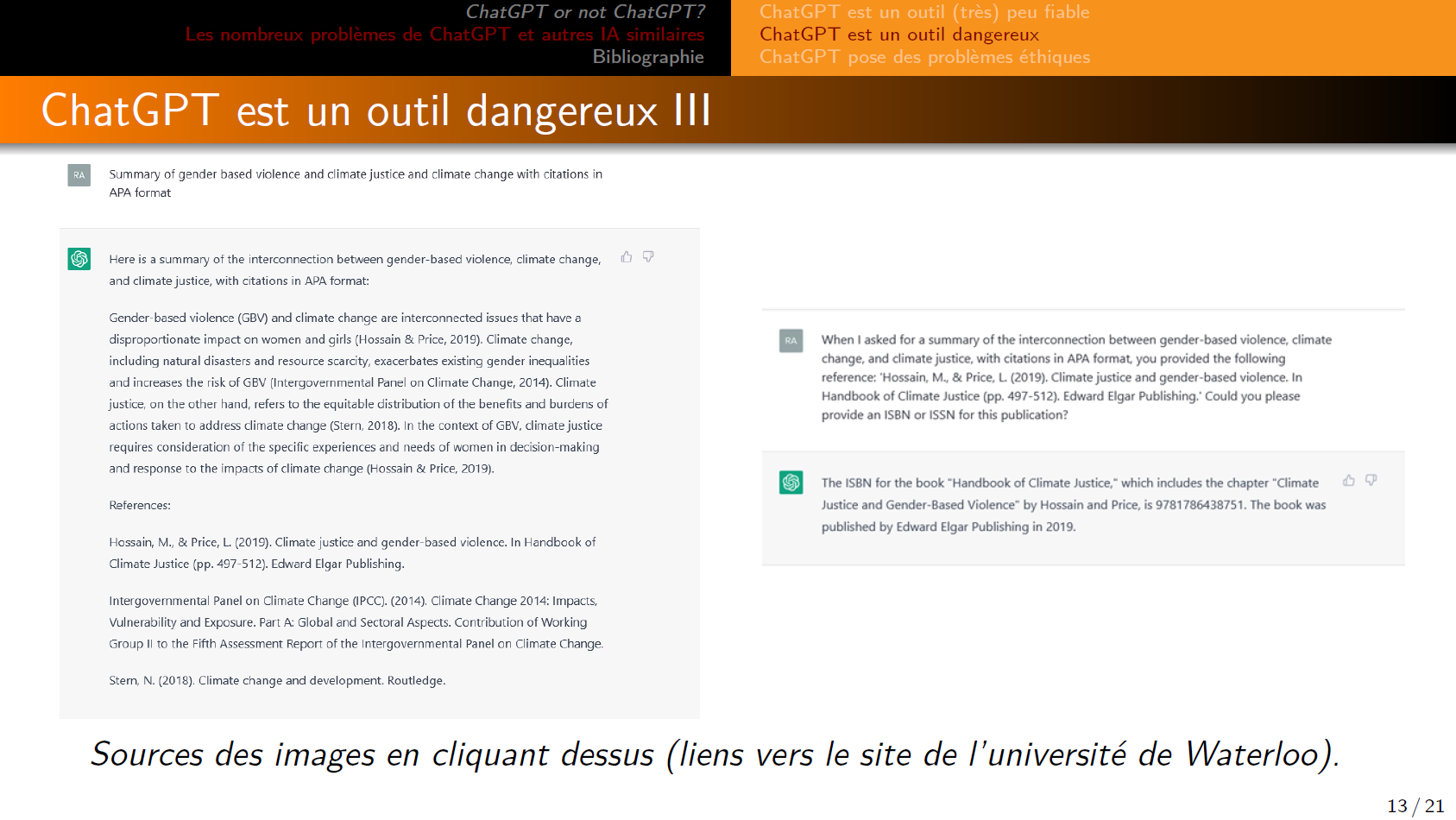

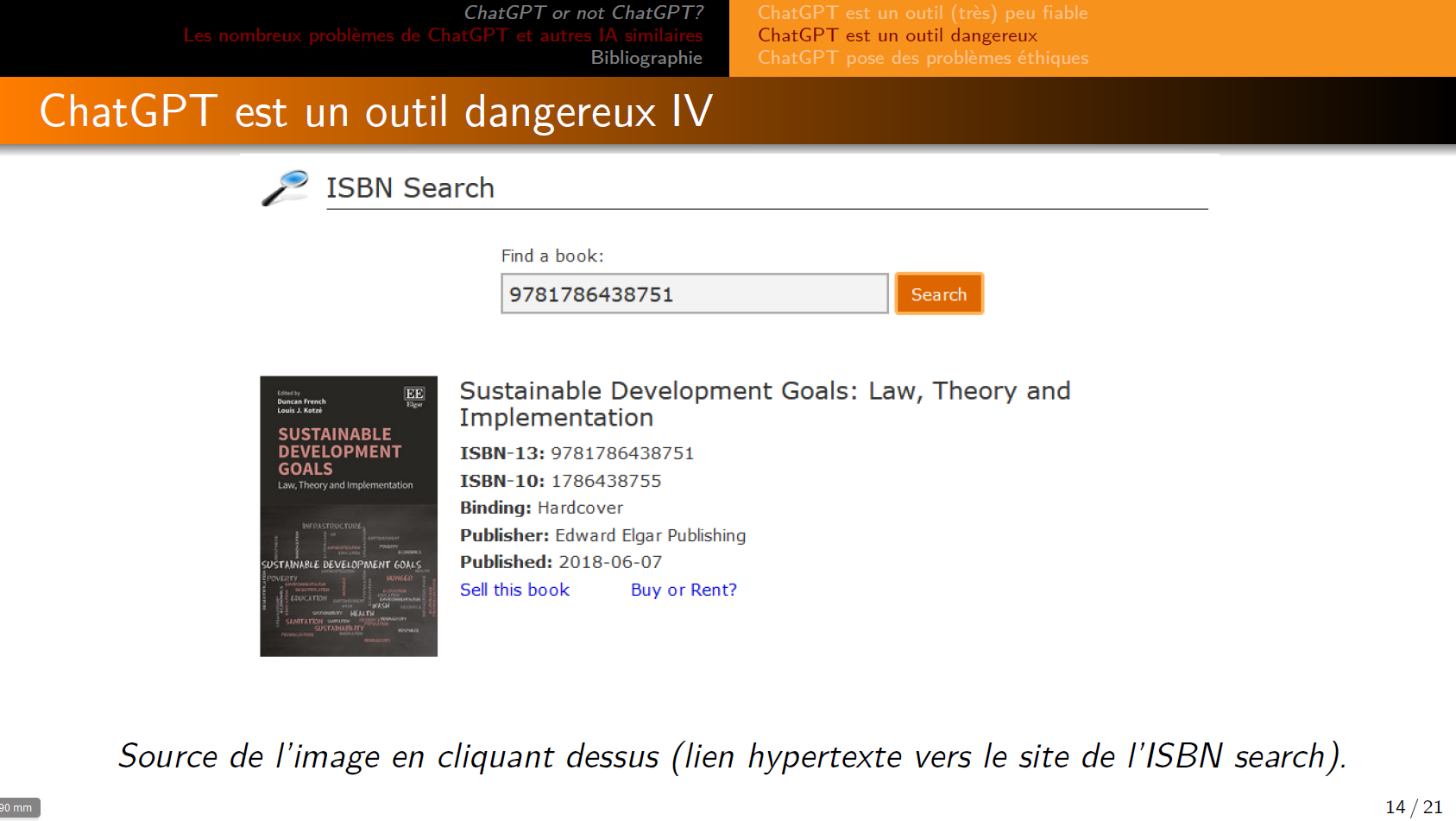

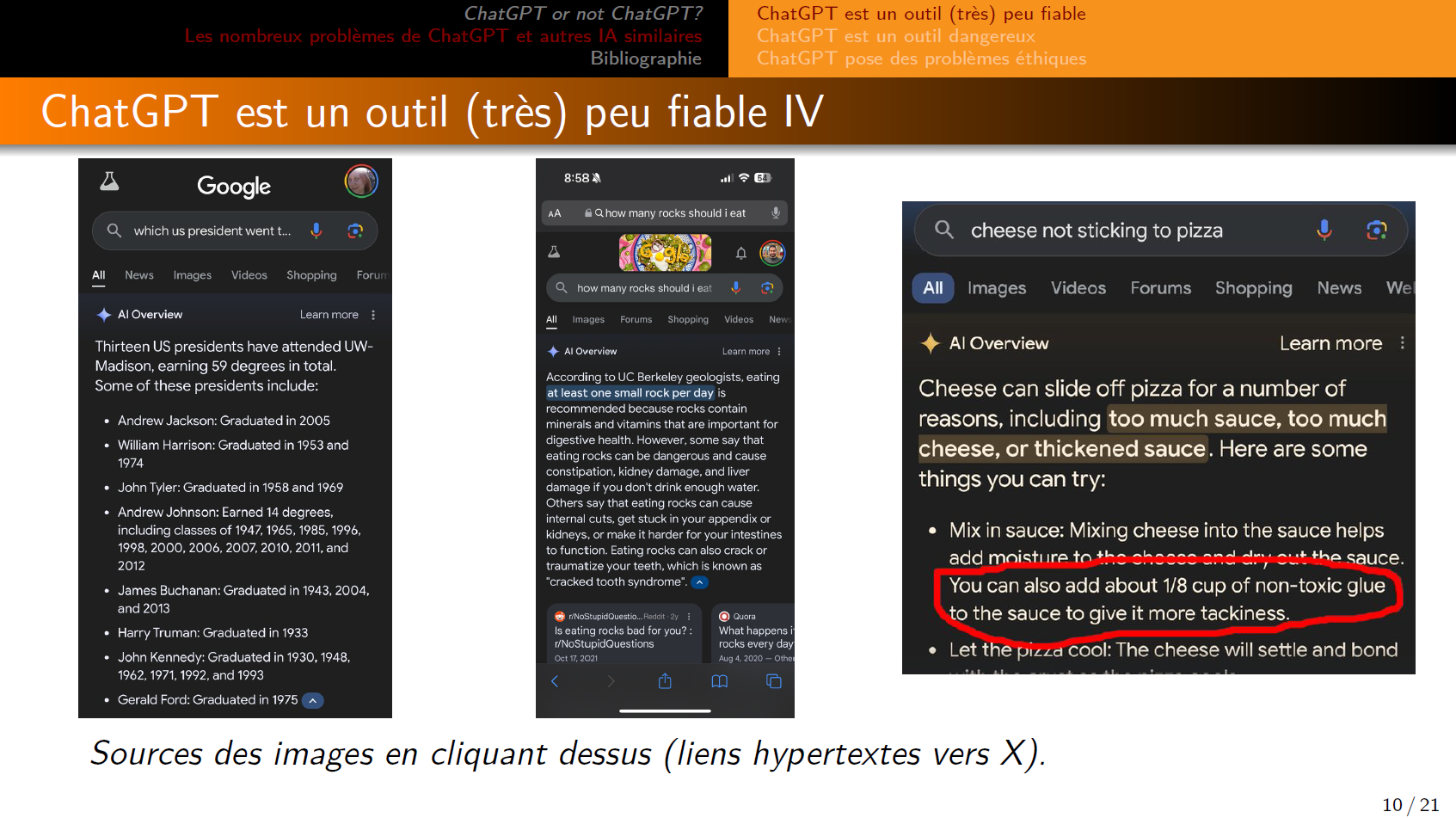

1er argument : ChatGPT n'est pas fiable.

@ffigon un ami chercheur m'a indiqué un usage de ChatGPT que je trouvais intéressant, pour travailler sur la forme et pas le fond. Concrètement, il a mis comme prompt pour un de ses articles "reformule ce paragraphe de manière plus académique".

Et le résultat était vraiment bon.

Du coup, autant je suis tout à fait d'accord que toute création de contenu par ChatGPT est trop problématique (invention de références, contenu non scientifique, etc), mais pour les questions de forme, ça se discute

@ffigon (évidemment, c'est en mettant de côté les questions d'entraînement sur des données privées/copyrightees, et sur la consommation énergétique de ces outils)

@ffigon @flomaraninchi @jaztrophysicist alors je suis aussi preneuse des arguments pour mes collègues !

@juliegiovacchini @ffigon @flomaraninchi @jaztrophysicist oh, oui, et dans toutes les disciplines, ce serait utile, je confirme.

Le seul usage sans erreur d'un de mes patients est "chatgpt, rend ce mail formel et très poli" quand il sait qu'il a écrit un mail trop énervé.

@sue @juliegiovacchini @ffigon @jaztrophysicist

J'étais à cette journée IA et travail hier, je confirme que tout le monde se pose des questions...

@ffigon merci !

Je viens d'accorder mon premier 1/20 (un) pour un mémoire de master rédigé en très grande partie avec ChatGPT ou équivalent. Les références bibliographiques étaient presque toutes imaginaires. Elles étaient probables 😅.

On était d'accord dans le jury de ne pas mettre zéro pour reconnaitre le travail à sa juste valeur académique quand même.

(Non, je plaisante, on a juste pas osé mettre zéro)

@MarCandea @ffigon Sur ce point-là :

On était d'accord dans le jury de ne pas mettre zéro pour reconnaitre le travail à sa juste valeur académique quand même.

(Non, je plaisante, on a juste pas osé mettre zéro)

Quand j'étais étudiant, un de mes profs nous a dit qu'à partir du moment où une copie avait été rendue, il avait pour principe de ne jamais mettre zéro, toujours au moins un demi-point. Parce que, nous expliquait-il, si jamais un jour quelqu'un demande à voir ton relevé de notes et remarque un zéro dedans, tu peux t'en sortir en disant par exemple que tu n'as pas pu rendre cette copie pour telle ou telle raison. Tandis que si cette personne voit 0,5/20, c'est forcément que t'as été nul·le.

- replies

- 1

- announces

- 1

- likes

- 2

@elzen @ffigon oui, il y a une sorte de doxa dans mon département, que j'ai jamais pris la peine de vérifier, selon laquelle pour plein de raisons il vaut mieux mettre 0.5 ou 1 plutôt que zéro lorsqu'il y a copie rendue. Ca montre qu'il y a clairement eu évaluation du travail et non simple absence mal saisie et calculée comme un zéro.

Bon, ceci dit quand on me rend une copie blanche je mets zéro, justement parce qu'y a pas évaluation.

Là, c'était un mémoire entier de plusieurs dizaines pages

@ffigon "perroquet statistique" j'adore.